Professional Documents

Culture Documents

Bearing Fault

Uploaded by

danianpdCopyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

Bearing Fault

Uploaded by

danianpdCopyright:

Available Formats

Bearing fault, Impeller fault, seal fault and cavitation are the main causes of breakdown in

a mono block centrifugal pump and hence, the detection and diagnosis of these mechanical

faults in a mono block centrifugal pump is very crucial for its reliable operation. Based on a

continuous acquisition of signals with a data acquisition system, it is possible to classify the

faults. This is achieved by the extraction of features from the measured data and employing

data mining approaches to explore the structural information hidden in the signals acquired.

In the present study, statistical features derived from the vibration data are used as the

features. In order to increase the robustness of the classifier and to reduce the data

processing load, dimensionality reduction is necessary. In this paper dimensionality

reduction is performed using traditional dimensionality reduction techniques and nonlinear

dimensionality reduction techniques. The effectiveness of each dimensionality reduction

technique is also verified using visual analysis. The reduced feature set is then classified

using a decision tree. The results obtained are compared with those generated by classifiers

such as Nave Bayes, Bayes Net and kNN. The effort is to bring out the better

dimensionality reduction techniqueclassifier combination.

Keywords

Mono block centrifugal pump; Statistical features; Nave Bayes; Bayes Net; Dimensionality

reduction techniques; Decision tree; Visual analysis

1. Introduction

Condition monitoring is used to find faults at an early stage [10] so that diagnosis and

correction of those faults can be initiated before they become more prominent and lead to

loss in productivity. Unexpected breakdown of mono block centrifugal pump parts increases

the down time and maintenance costs. This has motivated academic researchers and

industrial experts to focus their attention on such studies using the contemporary

techniques and algorithms available in this field.

Bearings fault, impeller fault, seal fault and cavitation [13] can cause serious problems such

as noise, high vibration, leakage etc. and degrade the performance of the mono block

centrifugal pump [12]. In order to keep the pump performing [35] at its best, different

methods of fault diagnosis have been developed and used effectively to detect the machine

faults at an early stage. Vibration analysis is the one of the prime tools to detect and

diagnose mono block centrifugal pump faults [11]. Vibration based pump condition

monitoring and diagnosis involves data acquisition from the mono block centrifugal pump,

feature extraction from the acquired data, feature selection, and interpreting the results.

Different methods and approaches are used for fault diagnosis. Rajakarunakaran et al. [21]

proposed a model for the fault detection of centrifugal pumping system using feed forward

network with back propagation algorithm and binary adaptive resonance network (ART1)

for classification of seven categories of faults in the centrifugal pumping system. In the work

reported by Sakthivel et al. [23]; the use of Support Vector Machines (SVMs) and Proximal

Support Vector Machines (PSVMs) as a tool for accurately identifying and classifying pump

faults was presented. SVM was found to have a slightly better classification capability than

PSVM. Sakthivel et al. [24] presented the use of decision tree and rough sets to generate

rules from statistical features extracted from vibration signals under good and faulty

conditions of a mono block centrifugal pump. A fuzzy classifier is built using decision tree

and rough set rules, tested and the results are compared with those generated by a PCA

based decision tree-fuzzy classifier. Sakthivel et al. [25] reported the use of statistical

features extracted from time domain signals for classification of faults in centrifugal pumps

using decision tree. For the fault classification of mono block centrifugal pump, Sakthivel et

al. [26] have used artificial immune recognition system (AIRS). The fault classification

efficiency of AIRS is compared with hybrid systems such as PCA-Nave Bayes and PCA-

Bayes Net. AIRS was found to outperform other hybrid systems. Wang and Chen [31]

introduced a fault diagnosis method for a centrifugal pump with frequency domain symptom

parameter using wavelet transforms for feature extraction, rough sets for rule generation

and fuzzy neural network for classification to detect faults and distinguish fault types at

early stages. Rafiee et al. [20] illustrated an artificial neural network (ANN)-based

procedure for fault detection and identification in gearboxes using a new feature vector

extracted from standard deviation of wavelet packet coefficients of vibration signals. The use

of vibration signals requires minimum instrumentation but the use of wavelet transforms

increases the computational requirements. M. Zhao et al. [42] employed TR-LDA based

dimensionality reduction technique for fault diagnosis of rolling element bearings. Y. Zhang

et al. [37] proposed an improved manifold learning algorithm by combining adaptive local

linear embedding and recursively applying normalised cut algorithm for nonlinear

dimensionality reduction, which was then proven to be effective in dealing with standard

test data sets as well as on the TennesseeEastman process. D.Q. Zhang et al. [36] proposed

an efficient dimensionality reduction algorithm called semi supervised dimensionality

reduction. Zhang et al. [38], [39] and [40] presented a novel feature extraction technique

called group sparse canonical correlation analysis (GSCCA). M.S. Baghshah et al. [2]

proposed a kernel based metric learning technique that can produce nonlinear

transformation of the input features resulting in better learning performance. Zhang et al.

[38], [39] and [40] proposed an improvement over the Isomap dimensionality reduction

technique called the Marginal Isomap (M-Isomap) which was able to provide better

separation of data clusters. F.P. Nie et al. [17] developed an algorithm to find the global

optimum for the orthogonal constrained trace ratio problem. Yaguo Lei et al. [33] proposed a

system for fault diagnosis of rolling element bearings based on empirical mode

decomposition (EMD), an improved distance evaluation technique and the combination of

multiple adaptive neuro-fuzzy inference systems (ANFISs). Van Tung Tran et al. [30]

discussed a combined fault diagnosis system for induction motor based on classification and

regression tree (CART) algorithm and ANFIS. Yaguo Lei [34] proposed fault diagnosis of

rotating machinery based on statistic analysis and ANFIS. Necla Togun and Sedat Baysec

[16] presented the application of genetic programming (GP) to predict the torque and brake

specific fuel consumption of a gasoline engine. In the work reported by Demetgul [5] fault

diagnosis of pneumatic systems using ANN was presented.

However, to the best of our knowledge, the comparison of traditional dimensionality

reduction techniques with nonlinear dimensionality reduction techniques for fault

classification of a mono block centrifugal pump has not been reported so far. This paper

investigates traditional dimensionality reduction technique PCA and the following nine

nonlinear dimensionality reduction techniques: (1) Kernel PCA, (2) Isomap, (3) Maximum

Variance Unfolding, (4) diffusion maps, (5) Locally Linear Embedding, (6) Laplacian

Eigenmaps, (7) Hessian LLE, (8) Local Tangent Space Analysis, and (9) manifold charting.

These dimensionality reduction techniques are used to transform statistical features

extracted from the pump vibration signals. Decision tree, nave Bayes Bayes Net and kNN

classifiers are then used to classify the faults. The main objectives of the work are:

(i)

To investigate to what extent the nonlinear dimensionality reduction techniques outperform

the traditional PCA on centrifugal pump data sets

(ii)

To find out the best dimensionality reduction techniqueclassifier combination.

2. Experimental studies

2.1. Experimental setup

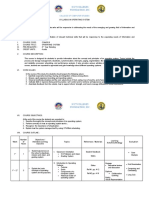

Fig. 1 shows the schematic diagram of the experimental test rig. The motor (2HP) drives the

pump. The control valve is used to adjust the flow at the inlet and the outlet of the pump.

The inlet valve is used to create pressure drop between the suction and at the eye of the

impeller to simulate cavitation. An accelerometer mounted at the eye of the impeller

(location shown in Fig. 1), is used to measure the vibration signals. This is due to the fact

that the mechanical components under consideration in the present study (seal, impeller,

bearing), are located close to the eye of the impeller.

Full-size image (63 K)

Fig. 1.

Experimental test rig.

Figure options

2.2. Experimental procedure

The vibration signals are acquired from the centrifugal pump working under normal

condition at a rated speed of 2880 rpm. Centrifugal pump specification is shown in Table 1.

Vibration signals from the accelerometer are measured. The sampling frequency is 24 kHz.

250 sets of readings are taken for each centrifugal pump condition.

Table 1.

Centrifugal pump specification.

Speed: 2880 rpm Pump size: 50 50 mm

Current: 11.5 A Discharge: 392 L per second

Head: 20 m Power: 2 HP

Table options

In the present study, the following faults are simulated

Bearing fault Inner and Outer race fault

Seal fault Broken seal

Impeller fault Damaged impeller

Bearing and Impeller fault together

Cavitation at the eye of the impeller

The faults are introduced one at a time and the pump performance characteristic and

vibration signals are taken.

3. Feature extraction

Statistical analysis of vibration signals yields different descriptive statistical parameters.

The statistical parameters taken for this study are mean, standard error, median, standard

deviation, sample variance, kurtosis, skewness, range, minimum, maximum, and sum.

These eleven features are extracted from vibration signals.

4. Dimensionality reduction techniques [14]

4.1. Linear dimensionality reduction techniques

4.1.1. Principle component analysis (PCA)

PCA is a linear technique for dimensionality reduction. It performs dimensionality reduction

by embedding the data into a linear subspace of lower dimensionality. PCA is one of the most

popular (unsupervised) techniques. Therefore, PCA is included in this comparative study.

PCA constructs a low-dimensional representation of the data that describes as much of the

variance in the data as possible. This is done by finding a linear basis of reduced

dimensionality for the data, in which the amount of variance in the data is maximal. The

basic working of a PCA is presented below.

Let x1, x2,, xn be N 1 vectors

Step 1

Mean value View the MathML sourceis calculated using the equation:

equation(1)

View the MathML source

Turn MathJax on

Step 2

The mean value is subtracted from each feature:

equation(2)

View the MathML source

Turn MathJax on

Step 3

Matrix A = [1, 2, ., N] is generated with and covariance matrix C is computed as

follows:

equation(3)

View the MathML source

Turn MathJax on

The covariance matrix characterizes the distribution of the data.

Step 4

Eigenvalues are computed as:

equation(4)

C=1>2>N

Turn MathJax on

Step 5

Eigenvectors are computed as:

equation(5)

C=u1,u2,uN

Turn MathJax on

Since C is symmetric, u 1, u 2,,u N form a basis, View the MathML source, can be

written as a linear combination of the eigenvectors:

equation(6)

View the MathML source

Turn MathJax on

where b1, b2,, bN are scalars.

Step 6

For dimensionality reduction, it keeps only the terms corresponding to the K largest

eigenvalues:

equation(7)

View the MathML source

Turn MathJax on

The representation of xx into the basis u1, u2,, uK is thus

equation(8)

View the MathML source

Turn MathJax on

4.2. Nonlinear dimensionality reduction techniques

4.2.1. Diffusion maps

Diffusion maps are based on defining a Markov random walk on the graph of the data. By

performing the random walk for a number of time steps, a measure for the proximity of the

data points is obtained. Using this measure, the diffusion distance is defined. The basic

working of diffusion map is presented below :

Step 1

A graph of the data is constructed first in the diffusion maps frame work. Using the

Gaussian Kernel function, the weights of the edges in the graph are computed, leading to a

matrix W with entries

equation(9)

View the MathML source

Turn MathJax on

where indicates the variance of the Gaussian.

Step2

normalization of the matrix W is performed in such a way that its rows add up to 1. In this

way, a matrix P(1) is formed with entries

equation(10)

View the MathML source

Turn MathJax on

Since diffusion maps originate from dynamical systems theory, the resulting matrix P(1) is

considered a Markov matrix that defines the forward transition probability matrix of a

dynamical process. Hence, the matrix P(1) represents the probability of a transition from one

data point to another data point in a single time step. The forward probability matrix for t

time steps P(t) is thus given by (P(1))t.

Step3Diffusion distance is defined using random walk forward probabilities View the

MathML source

equation(11)

View the MathML source

Turn MathJax on

In the above equation, (xk)(0) is a term that attributes more weight to parts of the graph

with high density. It is defined by (xk)(0)=mi/jmj, where m i is the degree of node x i

defined by mi=jpij

Step 4

In the low-dimensional representation of the data Y , diffusion maps attempt to retain the

diffusion distances. Using spectral theory on the random walk, the low-dimensional

representation Y that retains the diffusion distances D(t)(xi,xj) is formed by the d nontrivial

principal eigenvectors of the eigenproblem

equation(12)

P(t)v=v

Turn MathJax on

Because the graph is fully connected, the largest eigenvalue is trivial (viz. 1=1), and its

eigenvector v1 is thus discarded. The low-dimensional representation Y is given by the next

d principal eigenvectors. In the low-dimensional representation, the eigenvectors are

normalized by their corresponding eigenvalues. Hence, the low-dimensional data

representation is given by

equation(13)

Y={2v2,3v3,,d+1vd+1}

Turn MathJax on

4.2.2. Hessian LLE

Hessian LLE (HLLE) [7] is a variant of LLE that minimizes the curviness of the high-

dimensional manifold when embedding it into a low-dimensional space, under the constraint

that the low-dimensional data representation is locally isometric. This is done by an

eigenanalysis of a matrix H that describes the curviness of the manifold around the data

points. The curviness of the manifold is measured by means of the local Hessian at every

data point. The local Hessian is represented in the local tangent space at the data point, in

order to obtain a representation of the local Hessian that is invariant to differences in the

positions of the data points. It can be shown that the coordinates of the low-dimensional

representation can be found by performing an eigenanalysis of an estimator H of the

manifold Hessian.

Step 1

Identifying the k nearest neighbours for each data point xi using Euclidean distance.

Assume local linearity of the manifold in the neighbourhood.

Step 2

Applying PCA on its k nearest neighbours, the local tangent space at point xi can be found.

Step 3

An estimator for the Hessian of the manifold at point xi in local tangent space coordinates is

computed. In order to do this, a matrix Zi is formed that contains (in the columns) all cross

products of M up to the dth order.

Step 4

The matrix Zi is orthonormalized by applying Gram-Schmidt ortho-normalization [1].

The estimation of the tangent Hessian Hi is now given by the transpose of the last d(d + 1)/2

columns of the matrix Zi. Using the Hessian estimators in local tangent coordinates, a

matrix H is constructed

equation(14)

View the MathML source

Turn MathJax on

The matrix H represents information on the curviness of the high-dimensional data

manifold. An eigenanalysis of H is performed in order to find the low-dimensional data

representation that minimizes the curviness of the manifold. The eigenvectors corresponding

to the d smallest nonzero eigenvalues of H are selected and form the matrix Y, which

contains the low-dimensional representation of the data.

4.2.3. Isomap

Isomap [28] is a technique that attempts to preserve pairwise geodesic (or curvilinear)

distances between data points. Geodesic distance is the distance between two points

measured over the manifold.

Step 1

In Isomap, the geodesic distances between the data points xi (i = 1, 2,, n) are computed by

constructing a neighbourhood graph G, in which every data point xi is connected with its k

nearest neighbours xij (j = 1, 2,, k) in the data set X.

Step 2

The shortest path between two points in the graph forms an estimate of the geodesic

distance between these two points, and can easily be computed using Dijkstra's or Floyd's

shortest-path algorithm [6] and [8].

Step 3

The geodesic distances between all data points in X are computed, thereby forming a

pairwise geodesic distance matrix. The geodesic distances between all data points in X are

computed, thereby forming a pairwise geodesic distance matrix.

Step 4

The low-dimensional representations yi of the data points xi in the low-dimensional space Y

are computed by applying classical scaling.

4.2.4. Kernel PCA

Kernel PCA (KPCA) is the reformulation of traditional linear PCA in a high-dimensional

space that is constructed using a kernel function [27]. Kernel PCA computes the principal

eigenvectors of the kernel matrix, rather than those of the covariance matrix. The

reformulation of PCA in kernel space is straightforward, since a kernel matrix is similar to

the inner product of the data points in the high-dimensional space that is constructed using

the kernel function. The application of PCA in the kernel space provides Kernel PCA the

property of constructing nonlinear mappings.

4.2.5. Laplacian Eigenmaps

In Laplacian Eigenmaps, the local properties are based on the pairwise distances between

near neighbours. Laplacian Eigenmaps compute a low-dimensional representation of the

data in which the distances between a data point and its k-nearest neighbours are

minimized. This is done in a weighted manner, i.e., the distance in the low-dimensional data

representation between a data point and its first nearest neighbour contributes more to the

cost function than the distance between the data point and its second nearest neighbour.

Using spectral graph theory, the minimization of the cost function is defined as an

eigenproblem.

4.2.6. Local linear embedding (LLE)

LLE [22] is a technique similar to Isomap (and MVU) in that it constructs a graph

representation of the data points. In contrast to Isomap, it attempts to preserve solely local

properties of the data. As a result, LLE is less sensitive to short-circuiting than Isomap,

because only a small number of local properties are affected if short-circuiting occurs.

Furthermore, the preservation of local properties allows for successful embedding of non-

convex manifolds. In LLE, the local properties of the data manifold are constructed by

writing the high-dimensional data points as a linear combination of their nearest

neighbours. In the low-dimensional representation of the data, LLE attempts to retain the

reconstruction weights in the linear combinations as good as possible.

4.2.7. Local tangent space analysis (LTSA)

LTSA describes local properties of the high-dimensional data using the local tangent space of

each data point [41]. It is based on the observation that, if local linearity of the manifold is

assumed, there exists a linear mapping from a high-dimensional data point to its local

tangent space, and that there exists a linear mapping from the corresponding low-

dimensional data point to the same local tangent space. LTSA attempts to align these linear

mappings in such a way, that they construct the local tangent space of the manifold from the

low-dimensional representation.

4.2.8. Manifold charting

Manifold charting constructs a low-dimensional data representation by aligning a MoFA or a

MoPPCA model [4]. Manifold charting minimizes a convex cost function that measures the

amount of disagreement between the linear models on the global coordinates of the data

points. The minimization of this cost function can be performed by solving a generalized

eigenproblem.

4.2.9. Maximum variance unfolding (MVU)

MVU is a technique that attempts to resolve this problem by learning the kernel matrix.

MVU learns the kernel matrix by defining a neighbourhood graph on the data (as in Isomap)

and retaining pairwise distances in the resulting graph [32]. MVU is different from Isomap

in that it explicitly attempts to unfold the data manifold. It is done by maximizing the

Euclidean distances between the data points, under the constraint that the distances in the

neighbourhood graph are left unchanged (i.e., under the constraint that the local geometry of

the data manifold is not distorted). The resulting optimization problem can be solved using

semi definite programming.

5. Classifiers

5.1. Decision tree algorithm

A decision tree [19] represents the information in the signal, presented to it as features, in

the form of a tree. Decision trees are built recursively, following a top-down approach. A tree

induced using the C5.0 (or ID3 or C4.5) algorithm consists of a number of branches, one root,

a number of nodes and a number of leaves. One branch is a chain of nodes from root to a

leaf; and each node involves one attribute. Classification is done through the decision tree

with its leaves representing the different conditions of the mono block centrifugal pump.

5.1.1. The information gain and entropy reduction is calculated in the following way

Information gain measures how well a given attribute separates the training examples

according to their target classification. The measure is used to select among the candidate

features at each step while growing the tree. Information gain is the expected reduction in

entropy caused by partitioning the samples according to this feature.

Information gain (S , A ) of a feature A relative to a collection of examples S , is defined as

equation(15)

View the MathML source

Turn MathJax on

where Values(A ) is the set of all possible values for attribute A , and S v is the subset of S

for which feature A has value v (ie., Sv={sS|A(s)=v}).

The first term in the equation for Gain is the entropy (measure of disorder in the data) of the

original collection S and the second term is the expected value of the entropy after S is

partitioned using feature A. The expected entropy described by the second term is simply the

sum of the entropies of each subset Sv, weighed by the fraction of samples |Sv|/|S| that

belong to Sv. Gain(S, A) is therefore the expected reduction in entropy caused by knowing

the value of feature A. Entropy is a measure of homogeneity of the set of examples and it is

given by

equation(16)

View the MathML source

Turn MathJax on

where c is the number of classes, pi is the proportion of S belonging to class i.

5.2. Nave Bayes algorithm [29]

The Nave Bayes classifier is a highly practical Bayesian learning method. The following

description is based on the discussion in Ref. [15]. The Nave Bayes classifier applies to

learning tasks where each instance x is described by a conjunction of attribute values and

the target function f(x) can take on any value from some finite set C. A set of training

examples of the target function is provided, and a new instance is presented, described by

the tuple of attribute values (a1, a2,, an). The learner is asked to predict the target value,

or classification, for this new instance.

The Bayesian approach to classifying the new instance is to assign the most probable target

value, cMAP, given the attribute values (a1, a2,, an) that describe the instance.

equation(17)

View the MathML source

Turn MathJax on

Using Bayes theorem,

equation(18)

View the MathML source

Turn MathJax on

The Nave Bayes classifier makes the further simplifying assumption that the attribute

values are conditionally independent given the target value. Therefore,

equation(19)

View the MathML source

Turn MathJax on

where cNB denotes the target value output by the Nave Bayes classifier.

The conditional probabilities P(ai|cj) need to be estimated from the training set. The prior

probabilities P(cj) also need to be fixed in some fashion (typically by simply counting the

frequencies from the training set). The probabilities for differing hypotheses (classes) can

also be computed by normalizing the values received for each hypothesis (class).

5.3. Bayes Net algorithm

Bayesian network [9] consists of a set of variables, V = {A1, A2,, AN} and a set of directed

edge, E, between variables, which form a directed acyclic graph (DAG) G = (V, E) where a

joint distribution of variables is represented by the product of conditional distributions of

each variable given its parents [3].Each node, Ai V represents a random variable and a

directed edge from Ai to Aj, (Ai, Aj) E, represents the conditional dependency between Ai

and Aj. In a Bayesian networks, each variable is independent on its non-descendants, given

a value of its parents in G. This independence encoded in G reduces the number of

parameters which is required to characterize a joint distribution, so that posterior

distribution can be efficiently inferred.

In a Bayesian network over V = {A1, A2,, An}, the joint distribution P(V) is the product of

all conditional distributions specified in the Bayesian network such as

equation(20)

View the MathML source

Turn MathJax on

where, P(Ai/Pai) is the conditional distribution of Ai, given Pai which denotes the parent set

of Ai. A conditional distribution for each variable has a parametric form that can be learnt by

the maximum likelihood estimation.

6. Results and discussion

The study of fault classification performance of mono block centrifugal pump using

traditional dimensionality reduction technique and nonlinear dimensionality reduction

techniques is discussed in the following phases:

(i)

Visual analysis of the reduced feature set.

(ii)

Comparison of dimensionality reduction techniques with decision tree, Bayes Net Nave

Bayes and kNN classifiers.

(iii)

Comparison of the above results with a stand-alone decision tree classifier.

As can be seen from Fig. 2, Fig. 3 and Fig. 4, different dimensionality reduction techniques

offer differing degrees of separation of different fault categories. From observation of the

above Fig. 2, Fig. 3 and Fig. 4 it is clear that kPCA and PCA provide the maximum

separation between different fault categories hence combining these dimensionality

reduction techniques with a classifier is very likely to yield a high degree of classification

accuracy. On the other hand, Hessian LLE based dimensionality reduction offers the least

visual separation between fault classes and hence is likely to result in very poor

classification accuracy when combined with a classifier. These assertions on the likely

impact of different dimensionality reduction techniques on the classification accuracy are

verified with the help of decision tree, nave Bayes, Bayes Net and kNN classifiers in the

subsequent sections. Table 1, Table 2, Table 3 and Table 4 show the classification accuracy

obtained using decision tree, Bayes Net, Nave Bayes and kNN classifiers respectively, with

various nonlinear dimensionality reduction techniques and PCA. It must be noted that

normalisation is performed on all the features before the process of dimensionality reduction

is carried out. From Table 1, Table 2, Table 3 and Table 4 among the nonlinear

dimensionality reduction techniques and PCA, the PCA outperforms when using decision

tree, Bayes Net, Nave Bayes and kNN classifiers. In this work, the lowest accuracy is

obtained by the Hessian LLE transformed features with all the four classifiers. PCA-decision

tree classifier outperforms the other three classifiers, namely, PCA-nave Bayes, PCA-Bayes

Net and PCA-kNN. Fig. 5 shows the plot of various dimensionality reduction techniques and

their percentage classification accuracy with decision tree, nave Bayes, Bayes Net and kNN

classifiers. The overall classification accuracy was found to be 99.45% for the PCA-decision

tree classifier, which is slightly higher than the overall classification accuracy of PCA-kNN

(99.43%), PCA-Nave Bayes (99.3%) and PCA-Bayes Net (99.18%) (Table 5).

Indonesia:

Bantalan kesalahan , Impeller kesalahan , segel kesalahan dan kavitasi adalah penyebab

utama kerusakan dalam mono blok pompa sentrifugal dan karenanya , deteksi dan

diagnosis ini kesalahan mekanik dalam mono blok pompa sentrifugal sangat penting untuk

operasi yang dapat diandalkan . Berdasarkan akuisisi kontinu sinyal dengan sistem akuisisi

data , adalah mungkin untuk mengklasifikasikan kesalahan . Hal ini dicapai dengan

ekstraksi fitur dari data diukur dan menggunakan pendekatan data mining untuk

mengeksplorasi informasi struktural yang tersembunyi dalam sinyal yang diperoleh . Dalam

penelitian ini , fitur statistik yang berasal dari data getaran digunakan sebagai fitur .

Dalam rangka meningkatkan ketahanan classifier dan untuk mengurangi beban

pengolahan data , pengurangan dimensi diperlukan . Dalam hal ini pengurangan kertas

dimensi dilakukan dengan menggunakan teknik pengurangan dimensi tradisional dan

teknik pengurangan dimensi nonlinear . Efektivitas setiap teknik pengurangan dimensi

juga diverifikasi menggunakan analisis visual. Menurunnya set fitur ini kemudian

diklasifikasikan menggunakan pohon keputusan . Hasil yang diperoleh dibandingkan

dengan yang dihasilkan oleh pengklasifikasi seperti Nave Bayes , Bayes Net dan kNN .

Upaya ini untuk membawa keluar pengurangan dimensi kombinasi teknik - classifier yang

lebih baik .

Keywords

Mono blok pompa sentrifugal ; Fitur statistik ; Nave Bayes ; Bayes Net ; Teknik

pengurangan dimensi ; Pohon keputusan ; analisis Visual

1 . Pendahuluan

Pemantauan kondisi digunakan untuk mencari kesalahan pada tahap awal [ 10 ] sehingga

diagnosis dan koreksi kesalahan tersebut dapat dimulai sebelum mereka menjadi lebih

menonjol dan menyebabkan hilangnya produktivitas . Kerusakan tak terduga mono blok

bagian pompa sentrifugal meningkatkan waktu dan pemeliharaan menurunkan biaya . Hal

ini telah memotivasi peneliti akademis dan ahli industri untuk memusatkan perhatian

mereka pada studi tersebut menggunakan teknik kontemporer dan algoritma yang tersedia

di bidang ini .

Bearing kesalahan , kesalahan impeller , segel kesalahan dan kavitasi [ 13 ] dapat

menyebabkan masalah serius seperti kebisingan , getaran tinggi , dll kebocoran dan

menurunkan kinerja dari mono block pompa sentrifugal [ 12 ] . Dalam rangka menjaga

pompa melakukan [ 35 ] yang terbaik , metode yang berbeda dari kesalahan diagnosis telah

dikembangkan dan digunakan secara efektif untuk mendeteksi kesalahan mesin pada tahap

awal . Analisis getaran adalah salah satu alat utama untuk mendeteksi dan mendiagnosa

mono block kesalahan pompa sentrifugal [ 11 ] . Getaran berbasis pompa kondisi

pemantauan dan diagnosis melibatkan akuisisi data dari mono block pompa sentrifugal ,

ekstraksi fitur dari data yang diperoleh , seleksi fitur , dan menafsirkan hasilnya.

Metode dan pendekatan yang berbeda digunakan untuk diagnosis kesalahan .

Rajakarunakaran et al . [ 21 ] mengusulkan model untuk mendeteksi kesalahan sistem

pompa sentrifugal menggunakan jaringan umpan maju dengan algoritma propagasi

belakang dan biner jaringan resonansi adaptif ( ART1 ) untuk klasifikasi dari tujuh kategori

kesalahan dalam sistem pompa sentrifugal . Dalam pekerjaan yang dilaporkan oleh

Sakthivel et al . [ 23 ] ; penggunaan Support Vector Machines ( SVM ) dan proksimal

Support Vector Machines ( PSVMs ) sebagai alat untuk secara akurat mengidentifikasi dan

mengklasifikasikan kesalahan pompa disajikan . SVM ditemukan memiliki kemampuan

klasifikasi sedikit lebih baik daripada PSVM . Sakthivel et al . [ 24 ] mempresentasikan

penggunaan pohon keputusan dan set kasar untuk menghasilkan aturan dari fitur statistik

yang diekstrak dari sinyal getaran dalam kondisi baik dan rusak dari mono block pompa

sentrifugal . Sebuah classifier fuzzy dibangun dengan menggunakan pohon keputusan dan

set aturan kasar , diuji dan hasilnya dibandingkan dengan yang dihasilkan oleh keputusan

pohon - kabur classifier berbasis PCA . Sakthivel et al . [ 25 ] melaporkan penggunaan fitur

statistik yang diambil dari sinyal domain waktu untuk klasifikasi kesalahan dalam pompa

sentrifugal menggunakan pohon keputusan . Untuk klasifikasi kesalahan mono blok pompa

sentrifugal , Sakthivel et al . [ 26 ] telah menggunakan buatan sistem pengenalan kekebalan

(mengudara ) . Efisiensi Klasifikasi kesalahan mengudara dibandingkan dengan sistem

hibrida seperti PCA - Nave Bayes dan PCA - Bayes Net . Mengudara ditemukan untuk

mengungguli sistem hybrid lainnya . Wang dan Chen [ 31 ] memperkenalkan metode

diagnosis kesalahan untuk pompa sentrifugal dengan parameter domain frekuensi gejala

menggunakan transformasi wavelet untuk ekstraksi fitur , set kasar untuk pembangkitan

rule dan jaringan saraf fuzzy untuk klasifikasi untuk mendeteksi kesalahan dan

membedakan jenis kesalahan pada tahap awal . Rafiee et al . [ 20 ] diilustrasikan jaringan

saraf tiruan ( JST ) berbasis prosedur untuk deteksi kesalahan dan identifikasi di gearbox

menggunakan vektor fitur baru yang diambil dari standar deviasi wavelet packet koefisien

sinyal getaran . Penggunaan sinyal getaran memerlukan instrumentasi minimum tetapi

penggunaan transformasi wavelet meningkatkan kebutuhan komputasi . M. Zhao et al . [ 42

] dipekerjakan TR - LDA teknik pengurangan dimensi berbasis diagnosis kesalahan

bantalan elemen bergulir . Y. Zhang et al . [ 37 ] mengusulkan sebuah algoritma

pembelajaran berjenis ditingkatkan dengan menggabungkan adaptif embedding linear lokal

dan rekursif menerapkan algoritma cut dinormalisasi untuk pengurangan dimensi

nonlinear , yang kemudian terbukti efektif dalam menangani data uji standar set serta pada

proses Tennessee - Eastman . D.Q. Zhang et al . [ 36 ] mengusulkan sebuah algoritma

pengurangan dimensi yang efisien disebut semi diawasi pengurangan dimensi . Zhang et al .

[ 38 ] , [ 39 ] dan [ 40 ] disajikan teknik ekstraksi fitur baru yang disebut kelompok jarang

analisis korelasi kanonik ( GSCCA ) . M.S. Baghshah et al . [ 2 ] mengusulkan teknik

pembelajaran metrik berbasis kernel yang dapat menghasilkan transformasi nonlinier input

fitur menghasilkan kinerja belajar yang lebih baik . Zhang et al . [ 38 ] , [ 39 ] dan [ 40 ]

mengusulkan perbaikan atas teknik reduksi dimensi Isomap disebut Marginal Isomap ( M -

Isomap ) yang mampu memberikan pemisahan yang lebih baik dari cluster data. F.P. Nie et

al . [ 17 ] mengembangkan algoritma untuk menemukan optimum global untuk masalah

dibatasi jejak rasio orthogonal . Yaguo Lei et al . [ 33 ] mengusulkan sebuah sistem untuk

diagnosis kesalahan bantalan elemen bergulir berdasarkan modus empiris dekomposisi (

EMD ) , teknik perbaikan jarak evaluasi dan kombinasi dari beberapa adaptif sistem

inferensi neuro-fuzzy ( ANFISs ) . Van Tung Tran et al . [ 30 ] membahas sistem diagnosis

kesalahan gabungan untuk motor induksi berdasarkan klasifikasi dan pohon regresi (

CART ) algoritma dan ANFIS . Yaguo Lei [ 34 ] kesalahan diagnosis diusulkan mesin

berputar berdasarkan analisis statistik dan ANFIS . Necla Togun dan Sedat Baysec [ 16 ]

mempresentasikan aplikasi pemrograman genetik ( GP ) untuk memprediksi torsi dan rem

konsumsi bahan bakar spesifik mesin bensin . Dalam pekerjaan yang dilaporkan oleh

Demetgul [ 5 ] diagnosis kesalahan sistem pneumatik menggunakan JST disajikan .

Namun, untuk yang terbaik dari pengetahuan kita , perbandingan teknik pengurangan

dimensi tradisional dengan teknik pengurangan dimensi nonlinear untuk klasifikasi

kesalahan dari mono block pompa sentrifugal belum dilaporkan sejauh ini. Makalah ini

menyelidiki tradisional pengurangan dimensi teknik PCA dan berikut sembilan teknik

pengurangan dimensi nonlinear : ( 1 ) Kernel PCA , ( 2 ) Isomap , ( 3 ) Maksimum Variance

Unfolding , ( 4 ) peta difusi , ( 5 ) Lokal Embedding Linear , ( 6 ) Laplacian Eigenmaps , ( 7 )

Hessian LLE , ( 8 ) Lokal Tangent Analisis Ruang , dan ( 9 ) charting manifold. Teknik

pengurangan dimensi ini digunakan untuk mengubah fitur statistik yang diekstrak dari

sinyal getaran pompa . Pohon keputusan , naif Bayes Bayes Bersih dan kNN pengklasifikasi

kemudian digunakan untuk mengklasifikasikan kesalahan . Tujuan utama dari pekerjaan

ini adalah:

( i )

Untuk menyelidiki sejauh mana teknik pengurangan dimensi nonlinier mengungguli PCA

tradisional sentrifugal set data pompa

( ii )

Untuk mengetahui pengurangan dimensi kombinasi teknik - classifier terbaik .

2 . Studi Eksperimental

2.1 . setup eksperimental

Gambar . 1 menunjukkan diagram skematik dari rig uji eksperimental . Motor ( 2HP ) drive

pompa . Control valve digunakan untuk mengatur aliran di inlet dan outlet pompa. Katup

inlet digunakan untuk membuat penurunan tekanan antara suction dan di mata impeller

untuk mensimulasikan kavitasi . Sebuah accelerometer dipasang di mata impeller ( lokasi

ditunjukkan pada Gambar . 1 ) , digunakan untuk mengukur sinyal getaran . Hal ini

disebabkan oleh fakta bahwa komponen mekanis yang dipertimbangkan dalam penelitian

ini ( seal , impeller , bantalan ) , yang terletak dekat dengan mata impeller .

Full- size image ( 63 K )

Gambar . 1 .

Rig uji eksperimental .

Gambar Pilihan

2.2 . prosedur eksperimental

Sinyal getaran yang diperoleh dari pompa sentrifugal bekerja di bawah kondisi normal pada

peringkat kecepatan 2880 rpm . Spesifikasi pompa sentrifugal dapat dilihat pada Tabel 1 .

Sinyal Getaran dari accelerometer diukur . Frekuensi sampling 24 kHz . 250 set bacaan

yang diambil untuk setiap kondisi pompa sentrifugal .

Tabel 1 .

Pompa sentrifugal spesifikasi .

Kecepatan : 2880 rpm Ukuran Pompa : 50 50 mm

Current : 11,5 Discharge A : 392 L per detik

Kepala : 20 m Power: 2 HP

Pilihan tabel

Dalam penelitian ini , kesalahan berikut disimulasikan

Mengingat kesalahan - kesalahan batin dan ras Outer

Seal kesalahan - Patah seal

Impeller kesalahan - Rusak impeller

Bantalan dan Impeller kesalahan bersama-sama

Kavitasi - di mata impeller

Kesalahan diperkenalkan satu per satu dan karakteristik kinerja pompa dan sinyal getaran

diambil .

3 . Ekstraksi fitur

Analisis statistik sinyal getaran menghasilkan parameter statistik deskriptif yang berbeda .

Parameter statistik yang diambil untuk penelitian ini adalah rata-rata , standar error ,

median , standar deviasi , varians sampel , kurtosis , skewness , range, minimum ,

maksimum , dan jumlah . Ini sebelas fitur yang diekstraksi dari sinyal getaran .

4 . Teknik pengurangan dimensi [ 14 ]

4.1 . Teknik pengurangan dimensi linier

4.1.1 . Analisis komponen utama ( PCA )

PCA merupakan teknik linear untuk pengurangan dimensi . Ia melakukan pengurangan

dimensi dengan menanamkan data ke ruang bagian linear dari dimensi yang lebih rendah .

PCA adalah salah satu yang paling populer ( tanpa pengawasan ) teknik . Oleh karena itu ,

PCA termasuk dalam studi banding ini .

PCA membangun representasi low- dimensi dari data yang menggambarkan sebanyak

varians dalam data sebanyak mungkin . Hal ini dilakukan dengan mencari secara linear

berkurangnya dimensi untuk data , di mana jumlah varians dalam data yang maksimal .

Kerja dasar dari PCA disajikan di bawah ini .

Biarkan x1 , x2 , ... , xn menjadi N 1 vektor

Langkah 1

Nilai rata-rata Lihat MathML sourceis dihitung dengan menggunakan persamaan :

Persamaan ( 1 )

Lihat sumber MathML

Hidupkan MathJax on

Langkah 2

Nilai rata-rata dikurangi dari setiap fitur :

Persamaan ( 2 )

Lihat sumber MathML

Hidupkan MathJax on

Langkah 3

Matriks A = [ 1 , 2 , .... , N ] dihasilkan dengan dan matriks kovarians C dihitung

sebagai berikut :

Persamaan ( 3 )

Lihat sumber MathML

Hidupkan MathJax on

The matriks kovarians mencirikan distribusi data .

Langkah 4

Nilai Eigen dihitung sebagai :

Persamaan ( 4 )

C = 1 > 2 > ... N

Hidupkan MathJax on

Langkah 5

Vektor eigen dihitung sebagai :

Persamaan ( 5 )

C = u1 , u2 , ... uN

Hidupkan MathJax on

Karena C adalah simetris , u 1 , u 2 , ... , u N membentuk dasar , Lihat sumber MathML ,

dapat ditulis sebagai kombinasi linear dari vektor eigen :

Persamaan ( 6 )

Lihat sumber MathML

Hidupkan MathJax on

dimana b1 , b2 , ... , bn adalah skalar .

Langkah 6

Untuk pengurangan dimensi , itu membuat hanya istilah yang sesuai dengan nilai-nilai

eigen terbesar K :

Persamaan ( 7 )

Lihat sumber MathML

Hidupkan MathJax on

Representasi x x ke u1 dasar , u2 , ... , uk demikian

Persamaan ( 8 )

Lihat sumber MathML

Hidupkan MathJax on

4.2 . Teknik pengurangan dimensi nonlinier

4.2.1 . peta difusi

Peta Difusi didasarkan pada mendefinisikan Markov random walk pada grafik data .

Dengan melakukan berjalan acak untuk sejumlah langkah waktu , ukuran untuk

kedekatan titik data diperoleh . Menggunakan ukuran ini , jarak difusi didefinisikan . Kerja

dasar dari difusi peta adalah sebagai berikut :

Langkah 1

Sebuah grafik dari data yang dibangun pertama dalam difusi bingkai peta kerja .

Menggunakan fungsi Gaussian Kernel , bobot dari tepi dalam grafik dihitung , mengarah ke

matriks W dengan entri

Persamaan ( 9 )

Lihat sumber MathML

Hidupkan MathJax on

dimana menunjukkan varians dari Gaussian .

Step2

normalisasi matriks W dilakukan sedemikian rupa sehingga baris yang menambahkan

hingga 1 . Dengan cara ini , sebuah matriks P ( 1 ) dibentuk dengan entri

Persamaan ( 10 )

Lihat sumber MathML

Hidupkan MathJax on

Karena peta difusi berasal dari teori sistem dinamis , P matriks yang dihasilkan ( 1 )

dianggap sebagai matriks Markov yang mendefinisikan maju matriks peluang transisi dari

proses dinamis . Oleh karena itu , matriks P ( 1 ) merupakan probabilitas transisi dari satu

titik data untuk data titik lain dalam waktu satu langkah . Probabilitas matriks depan

untuk waktu t langkah P ( t ) dengan demikian diberikan oleh ( P ( 1 ) ) t .

Jarak Step3Diffusion didefinisikan menggunakan random walk probabilitas maju Lihat

sumber MathML

Persamaan ( 11 )

Lihat sumber MathML

Hidupkan MathJax on

Dalam persamaan di atas , ( xk ) ( 0 ) adalah istilah yang atribut lebih berat ke bagian

dari grafik dengan kepadatan tinggi . Hal ini didefinisikan oleh ( xk ) ( 0 ) = mi / jmj , di

mana mi adalah derajat simpul xi didefinisikan oleh mil = jpij

Langkah 4

Dalam representasi low - dimensi dari data Y , peta difusi berusaha untuk

mempertahankan jarak difusi . Menggunakan teori spektral pada random walk , rendah -

dimensi representasi Y yang mempertahankan jarak difusi D ( t ) (xi , xj ) dibentuk oleh

vektor eigen utama trivial d eigenproblem yang

Persamaan ( 12 )

P ( t ) v = v

Hidupkan MathJax on

Karena grafik terhubung penuh, eigenvalue terbesar adalah sepele (yaitu 1 = 1 ) , dan

vektor eigen v1 yang demikian dibuang . The low- dimensi representasi Y diberikan oleh

vektor eigen utama d berikutnya . Dalam representasi low - dimensi , vektor eigen yang

dinormalisasi dengan nilai eigen yang berhubungan. Oleh karena itu , representasi data

rendah - dimensi diberikan oleh

Persamaan ( 13 )

Y = { 2v2 , 3v3 , ... , d +1 vd +1 }

Hidupkan MathJax on

4.2.2 . Hessian LLE

Hessian LLE ( HLLE ) [ 7 ] adalah varian dari LLE yang meminimalkan ' curviness ' dari

manifold dimensi tinggi ketika embedding ke dalam ruang dimensi rendah , di bawah

kendala bahwa representasi data low- dimensi lokal isometrik . Hal ini dilakukan oleh

eigenanalysis dari H matriks yang menggambarkan curviness dari manifold sekitar titik

data. The curviness dari manifold diukur dengan cara Hessian lokal di setiap titik data. The

Hessian lokal diwakili dalam ruang tangen lokal pada titik data, untuk mendapatkan

representasi dari Hessian lokal yang invarian perbedaan posisi dari titik data . Hal ini

dapat ditunjukkan bahwa koordinat representasi low - dimensi dapat ditemukan dengan

melakukan eigenanalysis dari H estimator dari Hessian manifold.

Langkah 1

Mengidentifikasi k tetangga terdekat untuk setiap titik data xi menggunakan jarak

Euclidean . Asumsikan linearitas lokal manifold di lingkungan.

Langkah 2

Menerapkan PCA pada k tetangga terdekatnya , ruang tangen lokal pada titik xi dapat

ditemukan .

Langkah 3

Sebuah estimator untuk Hessian yang bermacam-macam pada titik xi dalam koordinat

ruang tangen lokal dihitung . Untuk melakukan hal ini , matriks Zi dibentuk yang berisi (

dalam kolom ) semua produk silang dari M naik ke urutan DTH .

Langkah 4

Matriks Zi adalah orthonormalized dengan menerapkan Gram - Schmidt orto- normalisasi [

1 ] .

Estimasi tangen Hessian Hi sekarang diberikan oleh transpos dari d terakhir ( d + 1 ) / 2

kolom dari matriks Zi . Menggunakan estimator Hessian di singgung lokal koordinat ,

matriks H dibangun

Persamaan ( 14 )

Lihat sumber MathML

Hidupkan MathJax on

Matriks H merupakan informasi tentang curviness dari dimensi tinggi berjenis data.

Sebuah eigenanalysis H dilakukan dalam rangka untuk menemukan representasi data

rendah - dimensi yang meminimalkan curviness yang bermacam-macam . Vektor eigen yang

sesuai dengan nilai-nilai eigen terkecil d nol dari H dipilih dan membentuk matriks Y , yang

berisi representasi low- dimensi data .

4.2.3 . Isomap

Isomap [ 28 ] adalah teknik yang mencoba untuk melestarikan geodesic berpasangan ( atau

lengkung ) jarak antara titik data . Jarak geodesik adalah jarak antara dua titik diukur dari

bermacam-macam.

Langkah 1

Di Isomap , jarak geodesik antara titik data xi (i = 1 , 2 , ... , n ) dihitung dengan

membangun lingkungan graph G , di mana setiap data titik xi terhubung dengan k nya

tetangga terdekat xij ( j = 1 , 2 , ... , k ) dalam kumpulan data X.

Langkah 2

Jalur terpendek antara dua titik dalam bentuk grafik perkiraan jarak geodesik antara dua

titik , dan dengan mudah dapat dihitung dengan menggunakan Dijkstra atau algoritma

shortest- path Floyd [ 6 ] dan [ 8 ] .

Langkah 3

Jarak geodesik antara semua titik data dalam X dihitung , sehingga membentuk matriks

jarak geodesic berpasangan . Jarak geodesik antara semua titik data dalam X dihitung ,

sehingga membentuk matriks jarak geodesic berpasangan .

Langkah 4

The low- dimensi representasi yi dari xi titik data dalam low - dimensi ruang Y dihitung

dengan menerapkan skala klasik .

4.2.4 . kernel PCA

Kernel PCA ( KPCA ) adalah reformulasi PCA linier tradisional dalam ruang dimensi tinggi

yang dibangun menggunakan fungsi kernel [ 27 ] . Kernel PCA menghitung vektor eigen

utama dari matriks kernel , daripada mereka dari matriks kovarians . The reformulasi PCA

dalam ruang kernel sangat mudah , karena matriks kernel mirip dengan produk inner dari

titik data dalam ruang dimensi tinggi yang dibangun menggunakan fungsi kernel .

Penerapan PCA dalam ruang kernel menyediakan Kernel PCA milik membangun pemetaan

nonlinear .

4.2.5 . Eigenmaps Laplacian

Dalam Laplacian Eigenmaps , sifat lokal didasarkan pada jarak berpasangan antara

tetangga dekat . Eigenmaps Laplacian menghitung representasi low- dimensi dari data di

mana jarak antara titik data dan k - terdekat tetangga diminimalkan . Hal ini dilakukan

dengan cara yang berbobot , yaitu , jarak dalam representasi data rendah - dimensi antara

titik data dan tetangga terdekat pertama memberikan kontribusi lebih kepada fungsi biaya

dari jarak antara titik data dan kedua tetangga terdekat . Menggunakan teori grafik

spektral , minimalisasi fungsi biaya didefinisikan sebagai eigenproblem .

4.2.6 . Linear embedding lokal ( LLE )

LLE [ 22 ] adalah teknik yang mirip dengan Isomap ( dan MVU ) dalam hal membangun

sebuah representasi grafik dari titik data . Berbeda dengan Isomap , ia mencoba untuk

melestarikan sifat semata-mata lokal data . Akibatnya , LLE kurang sensitif terhadap

hubungan arus pendek dari Isomap , karena hanya sejumlah kecil sifat lokal terpengaruh

jika arus pendek terjadi . Selain itu , pelestarian properti lokal memungkinkan untuk

embedding sukses manifold non - cembung . Di LLE , sifat lokal manifold data dibangun

dengan menulis titik data dimensi tinggi sebagai kombinasi linear dari tetangga terdekat

mereka . Dalam representasi low - dimensi data , LLE mencoba untuk mempertahankan

bobot rekonstruksi di kombinasi linear sebaik mungkin .

4.2.7 . Analisis ruang tangen lokal ( LTSA )

LTSA menggambarkan sifat lokal dari data dimensi tinggi menggunakan ruang tangen

lokal dari setiap titik data [ 41 ] . Hal ini didasarkan pada pengamatan bahwa , jika

linearitas lokal manifold diasumsikan , terdapat pemetaan linear dari titik data yang tinggi

- dimensi untuk ruang tangen lokal , dan bahwa ada pemetaan linear dari titik yang sesuai

data rendah - dimensi ke ruang tangen lokal yang sama . LTSA mencoba untuk

menyelaraskan ini pemetaan linear sedemikian rupa , sehingga mereka membangun ruang

tangen lokal yang bermacam-macam dari rendahnya representasi dimensi .

4.2.8 . charting Manifold

Charting Manifold membangun sebuah representasi data low- dimensi dengan

menyelaraskan sebuah MoFA atau model MoPPCA [ 4 ] . Charting Manifold meminimalkan

fungsi biaya cembung yang mengukur jumlah perselisihan antara model linear pada

koordinat global titik data . Meminimalkan fungsi biaya ini dapat dilakukan dengan

memecahkan eigenproblem umum .

4.2.9 . Varians maksimum berlangsung ( MVU )

MVU adalah teknik yang mencoba untuk menyelesaikan masalah ini dengan mempelajari

matriks kernel . MVU belajar matriks kernel dengan mendefinisikan grafik lingkungan

pada data ( seperti dalam Isomap ) dan mempertahankan jarak berpasangan dalam grafik

yang dihasilkan [ 32 ] . MVU berbeda dari Isomap dalam hal itu secara eksplisit mencoba

untuk ' terungkap ' manifold data. Hal ini dilakukan dengan memaksimalkan jarak

Euclidean antara titik-titik data, di bawah kendala bahwa jarak dalam grafik lingkungan

yang tersisa tidak berubah (yaitu , di bawah kendala bahwa geometri lokal manifold data

tidak terdistorsi ) . Masalah optimasi yang dihasilkan dapat diselesaikan dengan

menggunakan setengah pasti pemrograman .

5 . Classifiers

5.1 . Algoritma pohon keputusan

Sebuah pohon keputusan [ 19 ] mewakili informasi dalam sinyal , disajikan untuk itu

sebagai fitur , dalam bentuk pohon . Pohon keputusan dibangun secara rekursif , mengikuti

pendekatan top-down . Sebuah pohon diinduksi menggunakan C5.0 ( atau ID3 atau C4.5 )

algoritma terdiri dari sejumlah cabang , satu akar , sejumlah node dan jumlah daun . Satu

cabang adalah rantai node dari akar ke daun ; dan setiap node melibatkan satu atribut .

Klasifikasi dilakukan melalui pohon keputusan dengan daun mewakili kondisi yang

berbeda dari mono block pompa sentrifugal .

5.1.1 . Keuntungan informasi dan entropi pengurangan dihitung dengan cara sebagai

berikut

Gain Informasi mengukur seberapa baik suatu atribut tertentu memisahkan contoh

pelatihan sesuai dengan klasifikasi target mereka . Langkah ini digunakan untuk memilih

di antara fitur kandidat di setiap langkah saat tumbuh pohon . Information gain adalah

pengurangan diharapkan entropi disebabkan oleh partisi sampel sesuai dengan fitur ini .

Informasi gain ( S , A ) dari fitur A relatif terhadap koleksi contoh S , didefinisikan sebagai

Persamaan ( 15 )

Lihat sumber MathML

Hidupkan MathJax on

dimana Nilai ( A) adalah himpunan semua nilai yang mungkin untuk atribut A , dan S v

adalah bagian dari S yang menampilkan A memiliki nilai v ( mis. , Sv = { s S | A ( s ) = v } )

.

Istilah pertama dalam persamaan untuk Gain adalah entropi ( ukuran ketidakteraturan

dalam data ) dari koleksi asli S dan istilah kedua adalah nilai yang diharapkan dari entropi

setelah S dipartisi menggunakan fitur A. entropi yang diharapkan dijelaskan oleh kedua

istilah hanyalah jumlah dari entropi dari setiap bagian Sv , ditimbang oleh fraksi sampel |

Sv | / | S | milik Sv . Oleh karena itu, Gain ( S , A ) adalah penurunan diharapkan entropi

disebabkan dengan mengetahui nilai fitur A. Entropi adalah ukuran homogenitas dari

himpunan contoh dan diberikan oleh

Persamaan ( 16 )

Lihat sumber MathML

Hidupkan MathJax on

di mana c adalah jumlah kelas , pi adalah proporsi S milik class 'i' .

5.2 . Algoritma Nave Bayes [ 29 ]

The Nave Bayes classifier adalah metode pembelajaran Bayesian yang sangat praktis .

Uraian berikut ini didasarkan pada diskusi di Ref . [ 15 ] . The Nave Bayes classifier

berlaku untuk tugas-tugas belajar di mana setiap contoh x digambarkan oleh gabungan dari

nilai atribut dan fungsi sasaran f ( x ) dapat mengambil nilai apapun dari beberapa

himpunan berhingga C. Satu set contoh pelatihan fungsi target disediakan , dan contoh

baru disajikan , dijelaskan oleh tuple nilai atribut ( a1 , a2 , ... , an) . Pelajar diminta untuk

memprediksi nilai target , atau klasifikasi , misalnya baru ini .

Pendekatan Bayesian untuk mengklasifikasikan contoh baru adalah untuk menetapkan

nilai target yang paling mungkin , CMAP , mengingat nilai atribut ( a1 , a2 , ... , an) yang

menggambarkan contoh.

Persamaan ( 17 )

Lihat sumber MathML

Hidupkan MathJax on

Menggunakan teorema Bayes ,

Persamaan ( 18 )

Lihat sumber MathML

Hidupkan MathJax on

The Nave Bayes classifier membuat asumsi lebih menyederhanakan bahwa nilai atribut

yang bersyarat independen diberi nilai target . Oleh karena itu ,

Persamaan ( 19 )

Lihat sumber MathML

Hidupkan MathJax on

mana CNB menunjukkan nilai target produksi oleh classifier Nave Bayes .

Probabilitas bersyarat P ( ai | cj ) harus diperkirakan dari training set . Probabilitas

sebelum P ( cj ) juga perlu diperbaiki dalam beberapa mode ( biasanya dengan menghitung

frekuensi dari training set ) . Probabilitas untuk berbeda hipotesis ( kelas ) juga dapat

dihitung dengan normalisasi nilai-nilai yang diterima untuk setiap hipotesis ( kelas ) .

5.3 . Algoritma Net Bayes

Jaringan Bayesian [ 9 ] terdiri dari satu set variabel , V = { A1 , A2 , ... , AN } dan satu set

diarahkan tepi , E , antara variabel , yang membentuk grafik asiklik diarahkan ( DAG ) G =

( V , E ) dimana distribusi gabungan variabel diwakili oleh produk dari distribusi bersyarat

dari masing-masing variabel yang diberikan orang tuanya [ 3 ] . setiap node , Ai V

merupakan variabel acak dan tepi diarahkan dari Ai ke Aj , ( Ai , Aj ) E , merupakan

ketergantungan bersyarat antara Ai dan Aj . Dalam jaringan Bayesian , masing-masing

variabel independen non - keturunan , mengingat nilai orang tua di G. kemerdekaan ini

dikodekan dalam G mengurangi jumlah parameter yang diperlukan untuk menandai

distribusi gabungan , sehingga distribusi posterior dapat efisien tereka .

Dalam sebuah jaringan Bayesian atas V = { A1 , A2 , ... , An } , P distribusi gabungan ( V )

adalah produk dari semua distro bersyarat ditentukan dalam jaringan Bayesian seperti

Persamaan ( 20 )

Lihat sumber MathML

Hidupkan MathJax on

dimana , P ( Ai / Pai ) adalah distribusi bersyarat dari Ai , mengingat Pai yang

menunjukkan set induk dari Ai . Sebuah distribusi bersyarat untuk setiap variabel memiliki

bentuk parametrik yang dapat dipelajari oleh estimasi kemungkinan maksimum .

6 . Hasil dan Pembahasan

Studi tentang kinerja klasifikasi kesalahan mono blok pompa sentrifugal menggunakan

teknik pengurangan dimensi tradisional dan teknik pengurangan dimensi nonlinear

dibahas dalam tahap-tahap berikut :

( i )

Analisis visual berkurang set fitur .

( ii )

Perbandingan teknik pengurangan dimensi dengan pohon keputusan , Bayes Net Nave

Bayes dan kNN pengklasifikasi .

( iii )

Perbandingan hasil di atas dengan pohon keputusan classifier berdiri sendiri .

Seperti dapat dilihat dari Gambar . 2 , Gambar . 3 dan Gambar . 4 , teknik pengurangan

dimensi yang berbeda menawarkan berbagai tingkat pemisahan kategori kesalahan yang

berbeda . Dari pengamatan Gambar di atas . 2 , Gambar . 3 dan Gambar . 4 jelas bahwa

kPCA dan PCA memberikan pemisahan maksimum antara kategori kesalahan yang

berbeda maka menggabungkan teknik pengurangan dimensi ini dengan classifier yang

sangat mungkin untuk menghasilkan tingkat akurasi yang tinggi klasifikasi . Di sisi lain ,

Hessian LLE berbasis pengurangan dimensi menawarkan pemisahan visual yang paling

antara kelas kesalahan dan karenanya cenderung menghasilkan akurasi klasifikasi sangat

miskin bila dikombinasikan dengan classifier a . Pernyataan ini pada kemungkinan dampak

dari teknik pengurangan dimensi yang berbeda pada keakuratan klasifikasi diverifikasi

dengan bantuan pohon keputusan , naif Bayes , Bayes Net dan kNN pengklasifikasi di

bagian berikutnya . Tabel 1 , Tabel 2 , Tabel 3 dan Tabel 4 menunjukkan akurasi klasifikasi

diperoleh dengan menggunakan pohon keputusan , Bayes Net , Nave Bayes dan kNN

pengklasifikasi masing-masing , dengan berbagai teknik pengurangan dimensi nonlinear

dan PCA . Harus dicatat bahwa normalisasi dilakukan pada semua fitur sebelum proses

reduksi dimensi dilakukan . Dari Tabel 1 , Tabel 2 , Tabel 3 dan Tabel 4 di antara teknik

pengurangan dimensi nonlinear dan PCA , PCA melebihi ketika menggunakan pohon

keputusan , Bayes Net , Nave Bayes dan kNN pengklasifikasi . Dalam karya ini , akurasi

terendah diperoleh oleh Hessian LLE fitur ditransformasi dengan semua empat

pengklasifikasi . PCA - keputusan pohon classifier melebihi tiga lainnya pengklasifikasi ,

yaitu PCA - nave Bayes , PCA - Bayes Net dan PCA - kNN . Gambar . 5 menunjukkan plot

berbagai teknik pengurangan dimensi dan akurasi klasifikasi persentase mereka dengan

pohon keputusan , naif Bayes , Bayes Net dan kNN pengklasifikasi . Akurasi klasifikasi

keseluruhan ditemukan 99,45 % untuk pohon classifier PCA - keputusan , yang sedikit lebih

tinggi dari akurasi klasifikasi keseluruhan PCA - kNN ( 99,43 % ) , PCA - Nave Bayes ( 99,3

% ) dan PCA - Bayes Net ( 99,18 % ) ( Tabel 5 ) .

You might also like

- Estimation and Active Damping of Unbalance Forces in Jeffcott-Like Rotor-Bearing SystemsDocument22 pagesEstimation and Active Damping of Unbalance Forces in Jeffcott-Like Rotor-Bearing SystemsAnonymous LU3Dz3TKtVNo ratings yet

- How To Evaluate BoatsDocument14 pagesHow To Evaluate BoatsJuniorJavier Olivo FarreraNo ratings yet

- Cai 2020Document10 pagesCai 2020Nemer RaslenNo ratings yet

- Sensors: Naive Bayes Bearing Fault Diagnosis Based On Enhanced Independence of DataDocument17 pagesSensors: Naive Bayes Bearing Fault Diagnosis Based On Enhanced Independence of DataSérgio CustódioNo ratings yet

- Discriminant Feature Extraction of Motor Current Signal Analysis and Vibration For Centrifugal Pump Fault DetectionDocument6 pagesDiscriminant Feature Extraction of Motor Current Signal Analysis and Vibration For Centrifugal Pump Fault DetectionAsma'ul HusnaNo ratings yet

- Fault Detection System For Centrifugal Pumps Using Neural Networks and Neuro-Fuzzy TechniquesDocument9 pagesFault Detection System For Centrifugal Pumps Using Neural Networks and Neuro-Fuzzy TechniquesTetria AdwineldaNo ratings yet

- 1 s2.0 S0263224121002402 MainDocument19 pages1 s2.0 S0263224121002402 Mainvikas sharmaNo ratings yet

- Analysis of Permanent Magnet Synchronous MotorDocument15 pagesAnalysis of Permanent Magnet Synchronous Motormalini72No ratings yet

- Neurocomputing: P.K. Kankar, Satish C. Sharma, S.P. HarshaDocument8 pagesNeurocomputing: P.K. Kankar, Satish C. Sharma, S.P. Harshaharim_meNo ratings yet

- Pattern Recognition of Downhole Dynamometer Cards Using ANNsDocument4 pagesPattern Recognition of Downhole Dynamometer Cards Using ANNsCedric Kimloaz100% (1)

- SE Fuzzy MP 2012Document10 pagesSE Fuzzy MP 2012Cristian GarciaNo ratings yet

- Efficient Use of Hybrid Adaptive Neuro-Fuzzy Inference System Combined With Nonlinear Dimension Reduction Method in Production ProcessesDocument15 pagesEfficient Use of Hybrid Adaptive Neuro-Fuzzy Inference System Combined With Nonlinear Dimension Reduction Method in Production ProcessesCS & ITNo ratings yet

- Prediction of Critical Clearing Time Using Artificial Neural NetworkDocument5 pagesPrediction of Critical Clearing Time Using Artificial Neural NetworkSaddam HussainNo ratings yet

- Semeq PDFDocument19 pagesSemeq PDFluccadecarvalhoNo ratings yet

- Novel Method For Rolling Element Bearing Health Assessment-A Tachometer-Lesssynchronously Averaged Envelope Feature Extraction TechniqueDocument15 pagesNovel Method For Rolling Element Bearing Health Assessment-A Tachometer-Lesssynchronously Averaged Envelope Feature Extraction Techniquejun005No ratings yet

- Mahalanobis-Taguchi System As A Multi-Sensor Based Decision Making Prognostics Tool For Centrifugal Pump FailuresDocument15 pagesMahalanobis-Taguchi System As A Multi-Sensor Based Decision Making Prognostics Tool For Centrifugal Pump FailuresFELIPE ANDRÉS OLIVARES CODOCEONo ratings yet

- 1 s2.0 S0888327014001332 Main PDFDocument15 pages1 s2.0 S0888327014001332 Main PDFbasic joNo ratings yet

- Entropy: A New Feature Extraction Method Based On EEMD and Multi-Scale Fuzzy Entropy For Motor BearingDocument21 pagesEntropy: A New Feature Extraction Method Based On EEMD and Multi-Scale Fuzzy Entropy For Motor BearingAtoui IssamNo ratings yet

- DiagnosticsDocument4 pagesDiagnostics16061977No ratings yet

- Preprocessing-Free Gear Fault Diagnosis Using Small Datasets With Deep Convolutional Neural Network-Based Transfer LearningDocument13 pagesPreprocessing-Free Gear Fault Diagnosis Using Small Datasets With Deep Convolutional Neural Network-Based Transfer LearningCesar Vargas ArayaNo ratings yet

- Sensors: A Novel Method For Determining Angular Speed and Acceleration Using Sin-Cos EncodersDocument21 pagesSensors: A Novel Method For Determining Angular Speed and Acceleration Using Sin-Cos EncodersName24122021No ratings yet

- Cjme 2014 03 475Document8 pagesCjme 2014 03 475HASSANE HOTAITNo ratings yet

- Emcw 2001 Artesis PaperDocument5 pagesEmcw 2001 Artesis Paperವಿಶ್ವನಾಥ ಸಿNo ratings yet

- Sensors: Research On The Single-Value Indicators For Centrifugal Pump Based On Vibration SignalsDocument18 pagesSensors: Research On The Single-Value Indicators For Centrifugal Pump Based On Vibration SignalsAka ShriNo ratings yet

- Fast Calculation Method of Abnormality Degree For Real Time Abnormality Detection in Vehicle EquipmentDocument7 pagesFast Calculation Method of Abnormality Degree For Real Time Abnormality Detection in Vehicle EquipmentpriyankaprashaanthNo ratings yet

- Adaptive Feature Extraction and SVMDocument8 pagesAdaptive Feature Extraction and SVMHumberto MerizaldeNo ratings yet

- Engine Fault Diagnosis. A Novelty Detection ProblemDocument54 pagesEngine Fault Diagnosis. A Novelty Detection ProblemleonardohansaNo ratings yet

- Published: April 2020 Author:: Yuan Guo, Yu Sun and Kai WuDocument15 pagesPublished: April 2020 Author:: Yuan Guo, Yu Sun and Kai WuShankar KNo ratings yet

- Applied Sciences: Three-Dimensional Identification For Unbalanced Mass of Rotor Systems in OperationDocument14 pagesApplied Sciences: Three-Dimensional Identification For Unbalanced Mass of Rotor Systems in OperationMithra SNo ratings yet

- Journal - Jpe - 16-3 - 854351307 2Document13 pagesJournal - Jpe - 16-3 - 854351307 2Behrouz MinayiNo ratings yet

- 02chapter1 PDFDocument9 pages02chapter1 PDFmghgolNo ratings yet

- يسDocument13 pagesيسamine zdNo ratings yet

- Feature MapDocument9 pagesFeature Map이성군No ratings yet

- Optimisation of A Three-Dimensional Axial Pump Using An Artificial Neural Network, A Genetic Algorithm and A Navier-Stokes SolverDocument1 pageOptimisation of A Three-Dimensional Axial Pump Using An Artificial Neural Network, A Genetic Algorithm and A Navier-Stokes SolveravinashpatilNo ratings yet

- Applsci 11 04149 v2Document16 pagesApplsci 11 04149 v2Candra Ismail AlhakimNo ratings yet

- DC Motor Modeling and Parameter Identification Using Constraint OptimizationDocument12 pagesDC Motor Modeling and Parameter Identification Using Constraint Optimizationゞ『HaiDerツ98〆No ratings yet

- Biwasd PidDocument15 pagesBiwasd Pidchr kasimNo ratings yet

- Gaussian Mixture Models-Based Control Chart Pattern RecognitionDocument18 pagesGaussian Mixture Models-Based Control Chart Pattern Recognitionsam zak100% (1)

- Machine Learning Sensors Improve Power Transformer Fault DiagnosisDocument17 pagesMachine Learning Sensors Improve Power Transformer Fault DiagnosisTrisna YuliaNo ratings yet

- Anna University UG PG Project FormatDocument69 pagesAnna University UG PG Project Formatramya2212No ratings yet

- Identification of Modal Parameters From Nonstationary Ambient Vibration Data Using The Channel-Expansion TechniqueDocument9 pagesIdentification of Modal Parameters From Nonstationary Ambient Vibration Data Using The Channel-Expansion TechniqueAlex VCNo ratings yet

- Vibration Signal Diagnosis and Analysis of Rotating Machine by Utilizing Cloud ComputingDocument10 pagesVibration Signal Diagnosis and Analysis of Rotating Machine by Utilizing Cloud ComputingDrRajeev ChauhanNo ratings yet

- Fault Detection For Railway Traction Motor Bearing Through Leakage CurrentDocument7 pagesFault Detection For Railway Traction Motor Bearing Through Leakage CurrentpriyankaprashaanthNo ratings yet

- 37 Impeller Fault Detection For A Centrifugal Pump Using Principal Component Analysis of Tim PDFDocument12 pages37 Impeller Fault Detection For A Centrifugal Pump Using Principal Component Analysis of Tim PDFjayaram432No ratings yet

- Ce 3Document7 pagesCe 3inertiadrift4uNo ratings yet

- Article in Press: Recognition of Control Chart Patterns Using An Intelligent TechniqueDocument11 pagesArticle in Press: Recognition of Control Chart Patterns Using An Intelligent TechniquesreeshpsNo ratings yet

- Experimental Study On Acceleration Measurement of Ship Wave MotionsDocument4 pagesExperimental Study On Acceleration Measurement of Ship Wave MotionsJean David ChanNo ratings yet

- Fault Diagnosis in HEV Regenerative Braking SystemsDocument15 pagesFault Diagnosis in HEV Regenerative Braking SystemsAnonymous ugAY1fsF0aNo ratings yet

- A Neuro-Fuzzy Approach To Gear System Monitoring: Wilson Wang, Fathy Ismail, and Farid GolnaraghiDocument14 pagesA Neuro-Fuzzy Approach To Gear System Monitoring: Wilson Wang, Fathy Ismail, and Farid GolnaraghiPradeep KunduNo ratings yet

- Lou - Bearing Fault Diagnosis Based On Wavelet Transform and Fuzzy Inference PDFDocument19 pagesLou - Bearing Fault Diagnosis Based On Wavelet Transform and Fuzzy Inference PDFTudor CostinNo ratings yet

- BrazilianDocument16 pagesBrazilianNeerajNo ratings yet

- Modelbasedpredictivemaintenanceofchillers ACRA2014Document4 pagesModelbasedpredictivemaintenanceofchillers ACRA2014Prayogo BontanxNo ratings yet

- Bearing DefectsDocument13 pagesBearing Defectsjoshibec100% (1)

- Model-Based Prognostics of Gear Health Using Stochastic Non-Linear Dynamical ModelsDocument6 pagesModel-Based Prognostics of Gear Health Using Stochastic Non-Linear Dynamical Modelsejlebe mekaniNo ratings yet

- Cho 2021vdfDocument13 pagesCho 2021vdfbrian sanmbranoNo ratings yet

- System Identification and Modeling For Interacting and Non-Interacting Tank Systems Using Intelligent TechniquesDocument15 pagesSystem Identification and Modeling For Interacting and Non-Interacting Tank Systems Using Intelligent TechniquesMandy DiazNo ratings yet

- ISO 9001:2008 Research Organization Tracks Coronary StructuresDocument6 pagesISO 9001:2008 Research Organization Tracks Coronary StructuresMuthumari AyyakannuNo ratings yet

- Long-Term Applying: ON Computers, 1971Document4 pagesLong-Term Applying: ON Computers, 1971Phu Pham QuocNo ratings yet

- Stress AnalysisDocument6 pagesStress Analysisapi-3836286100% (4)

- Piping: Kevin D. Rafferty, P.E. Geo-Heat Center Klamath Falls, Oregon 97601Document19 pagesPiping: Kevin D. Rafferty, P.E. Geo-Heat Center Klamath Falls, Oregon 97601danianpdNo ratings yet

- Stress Analysis of Piping SystemsDocument108 pagesStress Analysis of Piping SystemsShijumon KpNo ratings yet

- Travel Itinerary: Afdn3UDocument6 pagesTravel Itinerary: Afdn3UdanianpdNo ratings yet

- Surface MetrologyDocument14 pagesSurface MetrologydanianpdNo ratings yet

- LM 317Document25 pagesLM 317Andres Morales GonzlezNo ratings yet

- Experimental Investigation of Thermal Conductivity and Heat Pipe Thermal Performance of ZnO NanofluidsDocument8 pagesExperimental Investigation of Thermal Conductivity and Heat Pipe Thermal Performance of ZnO NanofluidsdanianpdNo ratings yet

- Red PagesDocument146 pagesRed PagesmcastilhoNo ratings yet

- 26.2.3 Packet Tracer - Configure IP ACLs To Mitigate Attacks - ILMDocument5 pages26.2.3 Packet Tracer - Configure IP ACLs To Mitigate Attacks - ILMTRYST CHAMANo ratings yet

- TCM3.2L La 22PFL1234 D10 32PFL5604 78 32PFL5604 77 42PFL5604 77Document67 pagesTCM3.2L La 22PFL1234 D10 32PFL5604 78 32PFL5604 77 42PFL5604 77castronelsonNo ratings yet

- Inflight EntertainmentDocument10 pagesInflight EntertainmentNeha BhatiaNo ratings yet

- New Mold Xk3100-B3 Manual E-111Document13 pagesNew Mold Xk3100-B3 Manual E-111Alvaro Pulido HernandezNo ratings yet

- Printing - Tetrameshing A Volume in A Single Step - HM-3230Document7 pagesPrinting - Tetrameshing A Volume in A Single Step - HM-3230api-19817003No ratings yet

- Oracle 11g RAC Architecture OverviewDocument25 pagesOracle 11g RAC Architecture OverviewSaeed MeethalNo ratings yet

- Ramachandra Narayana Bhatta's Resume SummaryDocument2 pagesRamachandra Narayana Bhatta's Resume Summarydatadisk10No ratings yet

- Supplementary Exam BCT 10Document4 pagesSupplementary Exam BCT 10Kimutai Kirui AlphonceNo ratings yet

- HW Components of A ComputerDocument8 pagesHW Components of A ComputerRashi MrBRDNo ratings yet

- U1L1 An Introduction To Algorithms and ProgrammingDocument34 pagesU1L1 An Introduction To Algorithms and ProgrammingDunstan Junior MapumaNo ratings yet

- Memory and Shift RegisterDocument15 pagesMemory and Shift RegisterManishaMalhotra100% (1)

- Demo Information and Communication TechnologyDocument33 pagesDemo Information and Communication TechnologyPratibha ShindeNo ratings yet

- RX25GV1NB RX35GV1NB FTX25GV1NB FTX35GV1NB PDFDocument174 pagesRX25GV1NB RX35GV1NB FTX25GV1NB FTX35GV1NB PDFMalay K GhoshNo ratings yet

- Net Equalizer 3000 Series Data SheetDocument2 pagesNet Equalizer 3000 Series Data SheetEsteban GutierrezNo ratings yet

- 8086 SubtractionDocument2 pages8086 SubtractionMahakaalNo ratings yet

- Diane Apetsi ResumeDocument4 pagesDiane Apetsi ResumedapetsiNo ratings yet

- Plastic Memory Stores 1,000 Photos in 1 Cubic CentimeterDocument9 pagesPlastic Memory Stores 1,000 Photos in 1 Cubic CentimeterNavami Aykara JNo ratings yet

- 1era Evidencia Ingles SenaDocument5 pages1era Evidencia Ingles SenasergioNo ratings yet

- Algebra 2 Assignment in FactoringDocument6 pagesAlgebra 2 Assignment in Factoringricky fluor50No ratings yet

- 1st Mastery Test COMPUTERDocument2 pages1st Mastery Test COMPUTERJoyce Dela Rama JulianoNo ratings yet

- LAD Consulting Localizations CLL F040: Chilean Solution For INV / CSTDocument50 pagesLAD Consulting Localizations CLL F040: Chilean Solution For INV / CSTVinayNo ratings yet

- Pindex System InstructionsDocument6 pagesPindex System InstructionsJASPREETKAUR0410No ratings yet

- Exam Mapeh 8Document11 pagesExam Mapeh 8May Ann C. PayotNo ratings yet

- Ddar FW LogDocument990 pagesDdar FW LogFabian Aguero PicadoNo ratings yet

- Troubleshooting in SMLGDocument6 pagesTroubleshooting in SMLGrgil252No ratings yet

- ICCT College Operating Systems SyllabusDocument7 pagesICCT College Operating Systems SyllabusRaymond RamirezNo ratings yet

- Gaussian Functions Integral TableDocument3 pagesGaussian Functions Integral TableAllan David Cony TostaNo ratings yet

- Problem Space - Definition & StagesDocument2 pagesProblem Space - Definition & StagesChaman ShafiqNo ratings yet

- Bitcoin and Blockchain B094G62PPMDocument289 pagesBitcoin and Blockchain B094G62PPMDương Nguyễn BìnhNo ratings yet